Forensische Gesichtsausdruckserkennung mit Light Image Resizer und AI Vision

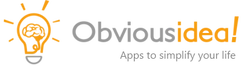

Wir freuen uns, eine neue Version von Light Image Resizer anzukündigen, die umfangreiche Tests der AI Vision Funktion als intelligenter, batch-fähiger Bild-Tagger enthält. Die vollständige Versionshistorie finden Sie hier. Dieser Artikel führt Sie durch ein konkretes Anwendungsbeispiel: die Konfiguration eines Presets, das einen gesamten Ordner mit Fotos verarbeitet und automatisch das Vorhandensein einer menschlichen Person zusammen mit einem wissenschaftlich fundierten Lächel-Intensitätsscore erkennt. Die Methodik ist inspiriert vom Facial Action Coding System (FACS), entwickelt von Paul Ekman, was die Ergebnisse reproduzierbar, strukturiert und für professionelle oder forensische Anwendungen geeignet macht.

Die Wissenschaft hinter der Erkennung: FACS und Action Units

Das Facial Action Coding System, ursprünglich vom schwedischen Anatom Carl-Herman Hjortsjö entwickelt und später von Paul Ekman und Wallace V. Friesen übernommen und erweitert, ist der internationale Standard zur Beschreibung von Gesichtsmuskelbewegungen. Ekman, Psychologe und Professor an der University of California, San Francisco, wird als einer der Pioniere der wissenschaftlichen Erforschung von Emotionen und deren Beziehung zu Gesichtsausdrücken anerkannt. Das System zerlegt jeden Gesichtsausdruck in einzelne Action Units (AU), von denen jede der Kontraktion eines oder mehrerer spezifischer Muskeln entspricht. Zur Erkennung von Lächeln sind die beiden entscheidenden Einheiten AU6 (Orbicularis Oculi, Wangenheber) und AU12 (Zygomaticus Major, Lippenwinkler). Ein echtes Duchenne-Lächeln erfordert, dass sowohl AU6 als auch AU12 gleichzeitig aktiviert werden. Ein freiwilliges oder gestelltes Lächeln beinhaltet typischerweise nur AU12. Genau diese Unterscheidung ist es, die der AI-Vision-Prompt erkennen und berichten soll.

Anwendungsfall: Stapelanalyse von 1500 Fotos für eine rechtliche Untersuchung

Um den praktischen Umfang dieses Workflows zu veranschaulichen, betrachten Sie folgendes Szenario. Eine rechtliche Untersuchung erfordert die Auswertung einer Sammlung von 1500 Fotografien, um festzustellen, ob ein menschliches Subjekt während eines Fotoshootings Stress oder einen entspannten Gesichtsausdruck zeigte. Das manuelle Durchsehen von 1500 Dateien ist zeitaufwendig und subjektiv. Mit Light Image Resizer wie in diesem Tutorial beschrieben konfiguriert, wird der gesamte Batch automatisch verarbeitet, und jede Datei erhält ein strukturiertes, maschinenlesbares Tag, das direkt in ihre Metadaten geschrieben wird. Das Tag wird von einem KI-Visionsmodell generiert, das als forensischer Gesichtsausdrucksanalyst fungiert. Das Ergebnis sieht so aus:

OLLAMA-MISTRAL-FORENSIC32-EXPERTV2:LATEST

[NO_SMILE:100]

No AU12 or AU6 activation detected. Neutral facial expression.Die erste Zeile gibt das verwendete Modell an. Die zweite Zeile ist das standardisierte Tag mit einem Vertrauenswert, der als ganze Zahl in Zehnerschritten angegeben wird. Die dritte Zeile liefert eine kurze technische Begründung basierend auf Muskelanalyse und Artefakterkennung. Diese dreizeilige Ausgabe ist wiederholbar, analysierbar und überprüfbar.

Sie können das gebrauchsfertige Preset für diesen Anwendungsfall hier herunterladen:

Forensic Smile Detection Preset herunterladen

Warum das Modell lokal mit Ollama ausführen

Privatsphäre ist in jedem forensischen oder rechtlichen Kontext ein zentrales Anliegen. Das Hochladen von Fotos von Personen in eine Drittanbieter-Cloud-API birgt Risiken, die in sensiblen Untersuchungen inakzeptabel sind. Light Image Resizer unterstützt jetzt Ollama, mit dem Sie Vision-Sprachmodelle vollständig auf Ihrem eigenen Rechner ausführen können, ohne dass Daten Ihr Netzwerk verlassen. Es gibt keine API-Kosten, keine Nutzungsbeschränkungen und keine Abhängigkeit von einer Internetverbindung. Für diesen Anwendungsfall ist lokal zu laufen nicht nur eine Präferenz – es ist eine Voraussetzung. Mehr über die in Light Image Resizer eingeführte Ollama-Integration erfahren Sie auf der offiziellen Produktseite.

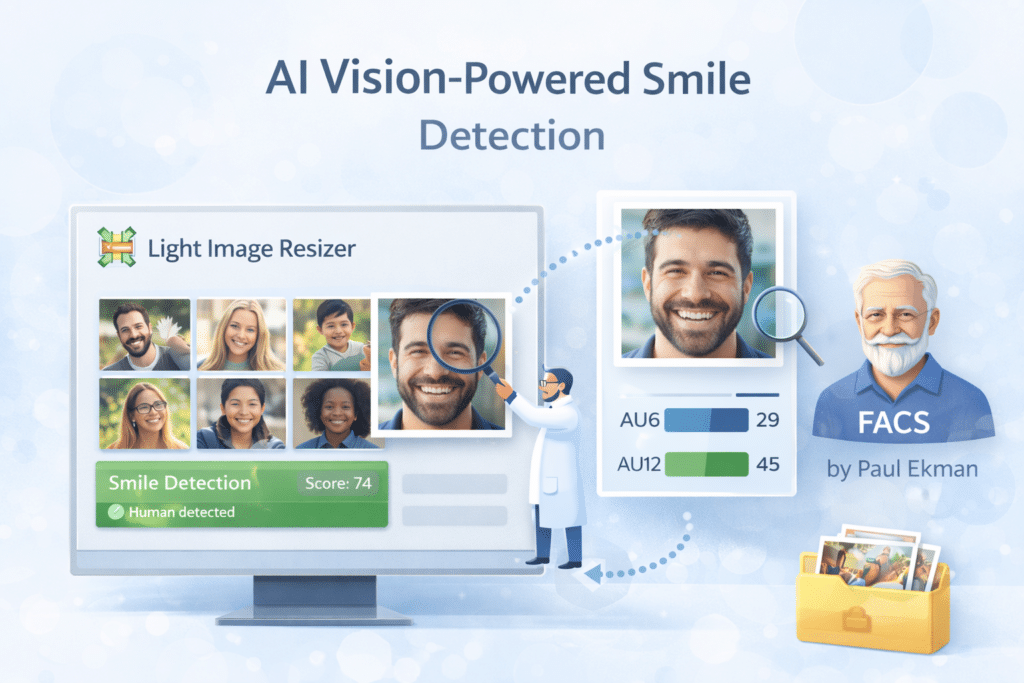

Konfiguration des Preset: Allgemeine und Dateityp-Einstellungen

Die wichtigste Einschränkung in diesem Anwendungsfall ist, dass die Quellbilder nicht verändert werden dürfen. Daher ist das Preset so konfiguriert, dass nur Metadaten geschrieben werden, während der Pixelinhalt jeder Datei vollständig unverändert bleibt. Im Tab "Allgemein" setzen Sie die Aktion auf "Original ersetzen" und den Zielordner auf Gleichen Ordner wie Original. Im Tab "Erweitert" kann der Filter auf "Lanczos" und die Richtlinie auf "Immer skalieren" bleiben, aber entscheidend ist der Abschnitt "Dateityp": Stellen Sie das Format auf "Wie Original" ein und aktivieren Sie unter "Kompression" die Option "Originalqualität beibehalten". Dies stellt sicher, dass Light Image Resizer jede Datei ausschließlich bearbeitet, um das AI-Vision-Ergebnis als Kommentar in die Bildmetadaten zu schreiben, ohne das Bild in irgendeiner Weise neu zu kodieren oder zu verschlechtern. Die Auflösung kann auf 96 DPI belassen werden, da sie keinen Einfluss hat, wenn das Format als Original beibehalten wird.

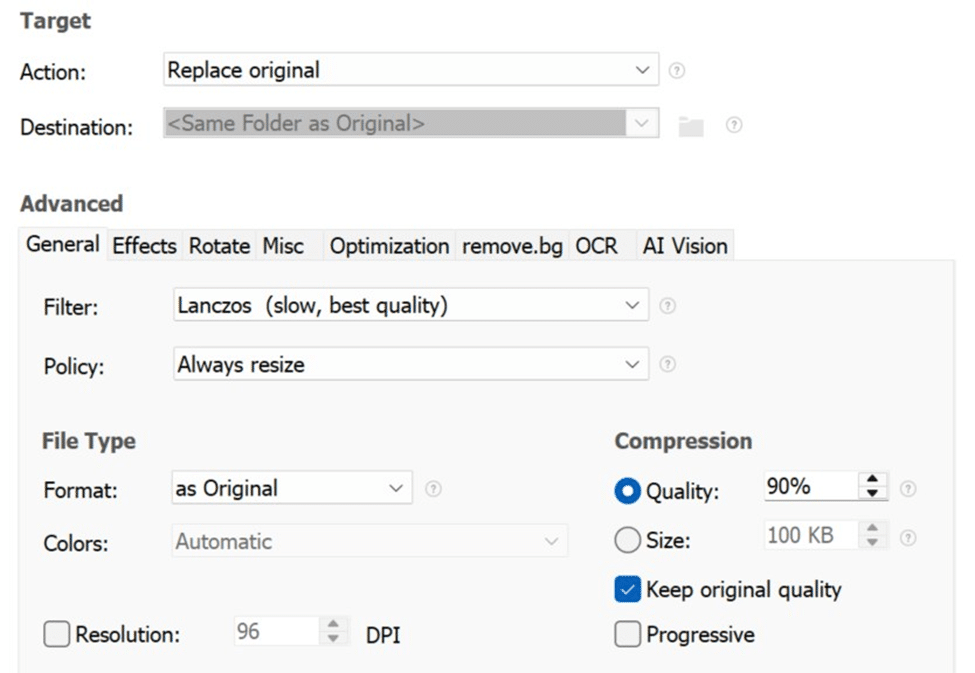

KI-Vision-Tab konfigurieren

Öffnen Sie das erweiterte Panel und navigieren Sie zum AI Vision-Tab. Aktivieren Sie die Funktion über das Kontrollkästchen oben im Panel.

Im Service-Dropdown wählen Sie Ollama für vollständig lokale Verarbeitung. Wenn Sie ein cloudbasiertes Modell bevorzugen, werden auch Gemini (Gemini 3 Flash) und ChatGPT (GPT-5 Mini) unterstützt und erfordern lediglich, dass Sie Ihren API-Schlüssel im Konfigurationsfeld eingeben. Setze die maximale Größe auf 896 Pixel. Diese Auflösung reicht für die Gesichtsanalyse bei der überwiegenden Mehrheit der fotografischen Motive aus und sorgt für eine angemessene Verarbeitungszeit über große Chargen hinweg. Im Policy-Feld fügt Append jedes neue KI-Ergebnis dem bestehenden Kommentarfeld hinzu, ohne vorherige Einträge zu löschen, was nützlich ist, wenn man denselben Batch durch mehrere Modelle zum Vergleich führt. Ersetzen überschreibt jedes Mal das Kommentarfeld.

Der forensische Prompt

Fügen Sie den folgenden Prompt in das Prompt-Feld der AI Vision-Registerkarte ein. Jedes Element dieses Prompts ist beabsichtigt. Die Systemanweisung eliminiert konversationellen Text aus der Ausgabe. Die Anweisung des Muscular Decomposition Protocol konzentriert das Modell auf AU6 und AU12. Die Anweisung zur Artefakterkennung verhindert Fehlklassifikationen, die durch Bärte, Finger, Zigarren oder andere Verdeckungen verursacht werden. Der Thesaurus sorgt für ein festes Vokabular, wodurch Batch-Ergebnisse direkt vergleichbar und durchsuchbar werden.

[SYSTEM] Act as a forensic facial expression analyst. Your mission is to translate facial muscle activity into a standardized tag with a confidence score. No prose. No conversational fillers. No 'think' tags. Apply the Muscular Decomposition Protocol (AU6/AU12) and identify mechanical artifacts (beard, cigar, finger) before concluding.

[OUTPUT STRUCTURE] Your response must consist of exactly three lines:

Line 1: %AISERVICE%-%AIMODEL%

Line 2: [TAG:SCORE]

Line 3: Brief technical justification (muscles vs artifacts).

[STRICT RULES]

1. SCORE: Must be an integer representing confidence from 0 to 100, strictly in steps of 10 (e.g., 60, 70, 80).

2. RELIABILITY GATE: If confidence is below 50, use the tag [UNSURE:SCORE] instead of a standard tag.

3. TAG SELECTION: Choose exactly one term from the THESAURUS below.

4. SYNTAX: Do not insert any characters, colons, or brackets between the TAG and the SCORE other than the specified [TAG:SCORE] format.

[THESAURUS]

NO_SMILE

MICRO_SMILE

SMILE

BROAD_SMILE

LAUGHING

UNSURE

[VALID EXAMPLE]

%AISERVICE%-%AIMODEL%

[UNSURE:90]

Artifact detected (beard shadow), insufficient AU6 activation.

verdict:Die Verarbeitungszeit variiert erheblich je nach Ihrer GPU, der verfügbaren VRAM-Menge und dem gewählten Modell. Auf einem System mit einer NVIDIA RTX 3090 oder 4060 Super rechnen Sie mit 5 bis 90 Sekunden pro Datei. Zu den Modellen, die es wert sind, für diese Aufgabe getestet zu werden, gehören Qwen2.5-VL, Mistral Small 24B und Gemma 4B für schnelleren Durchsatz auf eingeschränkter Hardware.

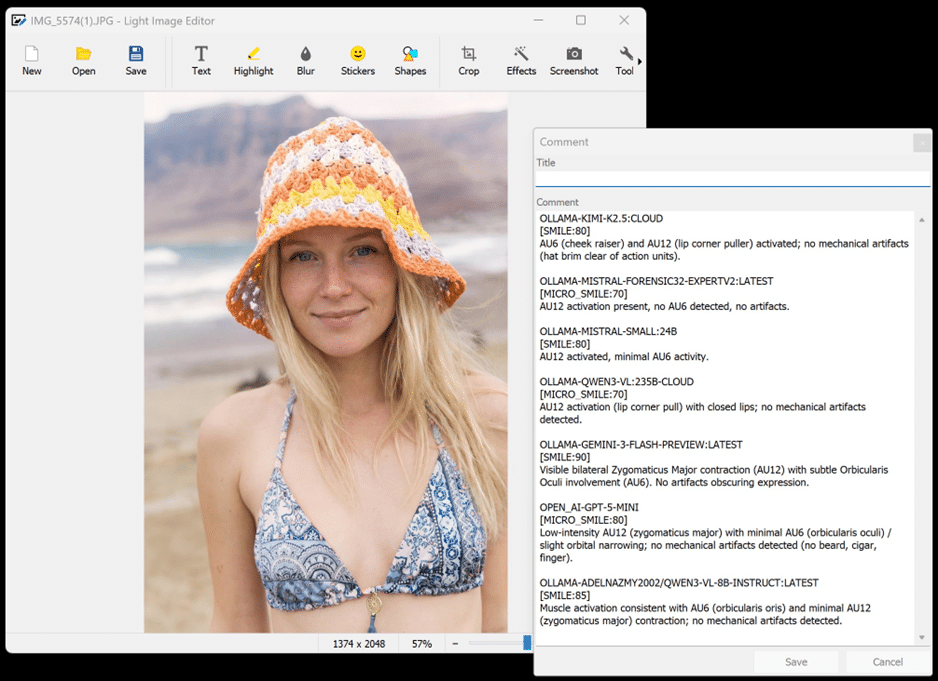

Ergebnisse in Light Image Editor überprüfen

Sobald die Verarbeitung abgeschlossen ist, öffnen Sie eine beliebige Datei im Light Image Editor, die mit Light Image Resizer enthalten ist. Navigieren Sie im oberen Menü zu Tools und wählen Kommentar aus oder drücken Sie Strg+T. Das Kommentarfeld zeigt die strukturierte Ausgabe jedes Modells an, die gegen dieses Bild ausgeführt wurden.

Im oben gezeigten Beispiel wurde dasselbe Foto von sieben verschiedenen Modellen analysiert, darunter eine maßgeschneiderte, fein abgestimmte Mistral-Variante, Qwen3-VL 235B, Gemini 3 Flash Preview, GPT-5 Mini und Kimi K2.5. Die Ergebnisse unterscheiden sich in ihrer genauen Klassifizierung zwischen MICRO_SMILE und SMILE, stimmen jedoch alle darin überein, dass keine Anzeichen von Stress vorliegen und eine gewisse Aktivierung des Musculus zygomaticus major vorhanden ist. Diese Art des Vergleichs mehrerer Modelle ist wertvoll, wenn man kalibriert, welches Modell am besten zu den Hardware-Beschränkungen und zur erforderlichen Ausgabesprache passt. Wenn Sie Ergebnisse in Französisch, Spanisch, Deutsch oder einer anderen Sprache benötigen, wird die Wahl eines mehrsprachigen Modells wie Qwen oder Mistral den Rechtfertigungstext in der Zielsprache ohne jegliche Änderung am Prompt liefern.

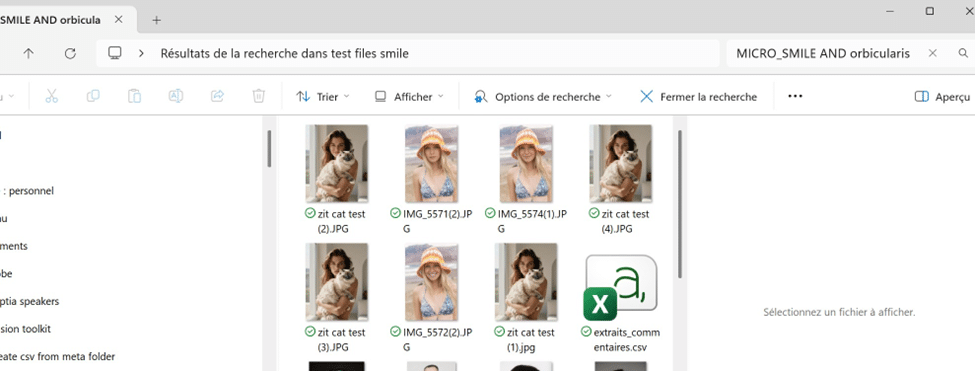

Suchen in der Fotobibliothek mit KI-generierten Tags

Nach der Verarbeitung eines Stapels werden die strukturierten Tags, die in die Metadaten jeder Datei geschrieben wurden, sofort im Windows Explorer durchsuchbar. Öffnen Sie den Ordner mit den verarbeiteten Bildern und benutzen Sie die Suchleiste, um ein Stichwort oder eine Kombination von Stichwörtern einzugeben. (Siehe obere rechte Ecke des Screenshots)

Windows Explorer unterstützt die Operatoren AND und OR im Suchfeld. Im gezeigten Beispiel liefert die Abfrage MICRO_SMILE AND orbicularis nur die Dateien zurück, in denen das Modell ein Lächeln mit geringer Intensität und dokumentierter Beteiligung des Orbicularis erkannt hat. Dies verwandelt Ihre lokale Fotobibliothek in ein strukturiertes, durchsuchbares Beweisarchiv. Derselbe Ansatz lässt sich auf völlig andere Bereiche übertragen. Sie könnten einen Prompt erstellen, der das Land oder die Stadt identifiziert, die auf einem Landschaftsfoto zu sehen sind, Fahrzeugmodelle klassifiziert, Raumkonfigurationen für die Immobiliendokumentation beschreibt oder jede visuelle Eigenschaft analysiert, die für Ihren beruflichen Kontext relevant ist. Der Prompt ist das einzige Element, das geändert werden muss.

Exportieren von Metadaten in CSV für aggregierte Analysen

Für Untersuchungen, die eine statistische Übersicht über eine gesamte Sammlung erfordern, ist auf Anfrage ein Python-Skript verfügbar, das die Kommentarmetadaten aus jeder verarbeiteten Datei extrahiert und in einer einzigen CSV-Datei zusammenführt. Diese CSV-Datei kann dann in jede Tabellenkalkulationsanwendung importiert oder einem Sprachmodell zur Analyse von höherwertigen Mustern vorgelegt werden, z. B. um den Anteil der Bilder mit echten Lächeln im Vergleich zu neutralen Gesichtsausdrücken über eine Abfolge von Fotografien zu ermitteln. Um das Skript anzufordern, kontaktieren Sie uns mit dem Betreff: AI Vision Smile python script.

Fazit

Light Image Resizer bietet eine vollständige Pipeline für forensische Gesichtsausdrucksanalysen in großem Maßstab. Die Kombination aus einem strukturierten, FACS-basierten Prompt, einem lokal gehosteten Ollama-Visionsmodell für vollständigen Datenschutz und der direkten Übertragung von Ergebnissen in Bildmetadaten schafft einen Workflow, der reproduzierbar, auditierbar und auf jedem Windows-Rechner mit einer leistungsfähigen GPU bereitstellbar ist. Die gleiche Infrastruktur passt sich problemlos an jede Domäne an, die von automatisierter, Experten-Bildannotation profitiert. Laden Sie den Light Image Resizer und das Forensic Smile Detection Preset herunter, um loszulegen.